AI-ansvar i en hajpad värld

Manage episode 440600033 series 3446305

Det är aldrig så lätt att bli lurad som under en pågående hajp. Det är mars 2023 och vi är mitt i den. Det är sällan jag sett så många anamma en helt ny experimentell lösning med så lite ifrågasättande. Just i detta nu är det oerhört viktigt att skaka av sig hypnosen och granska innehållet i den här nya flaskan med AI som flertalet börjat smutta på, eller redan börjat tanka sina företagsdatorer med. Ibland utan ledningens vetskap.

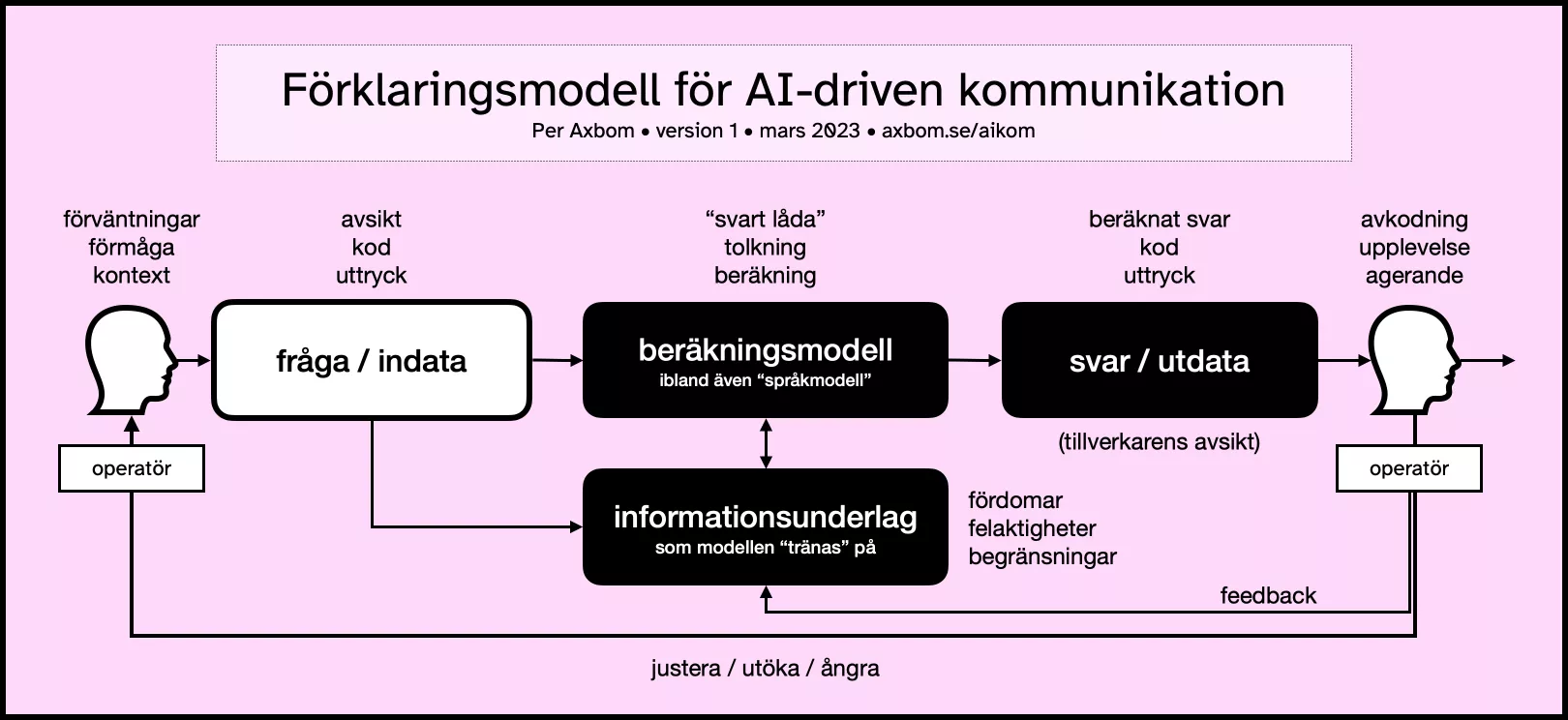

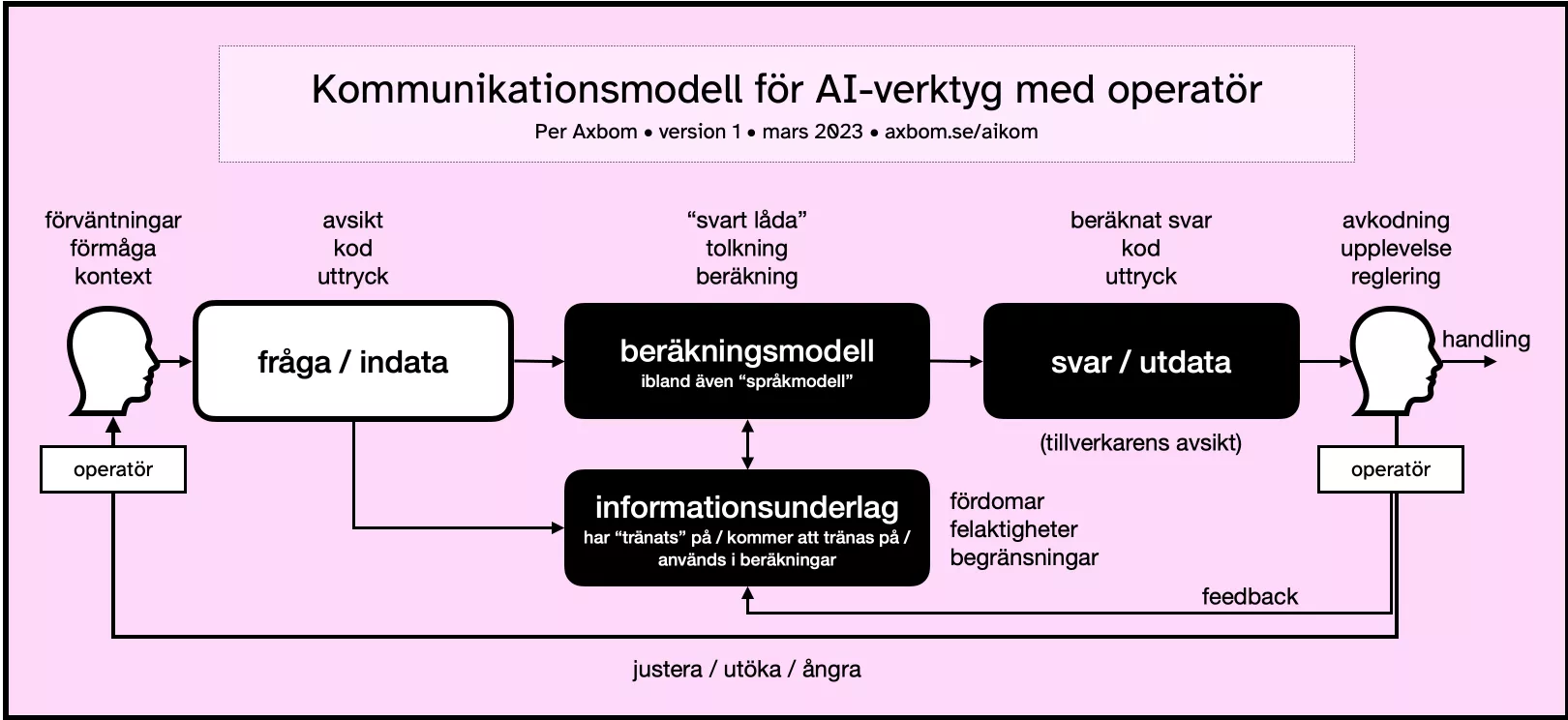

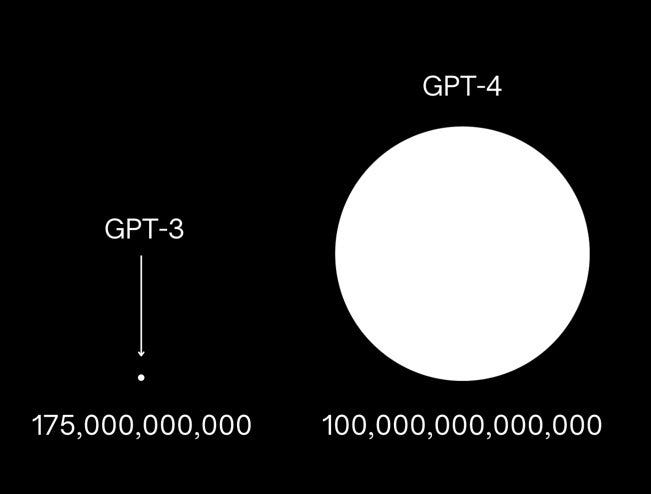

AI, ett begrepp som blev en akademisk inriktning 1956, har idag mest blivit ett marknadsföringsbegrepp för teknikföretag. Forskningsfältet grundar sig fortfarande i en teori om att mänsklig intelligens kan beskrivas så exakt att en maskin kan byggas som helt simulerar denna intelligens. Men ordet AI, när vi läser tidningen, beskriver oftast olika typer av matematiska beräkningsmodeller som, när de appliceras på stora mängder information, är tänkta att räkna ut och visa upp ett resultat som är underlag för olika former av förutsägelser, beslut och rekommendationer.

Tydligt svaga punkter i dessa beräkningsmodeller blir då till exempel:

- hur frågor ställs till beräkningsmodellen (man kan behöva ha väldigt specifika formuleringar för att få de resultat man vill ha),

- informationen den vilar sig mot för att göra sin uträkning (ofta fördomsfull eller otillräcklig),

- hur beräkningsmodellen faktiskt gör sin beräkning (det får vi alltför sällan veta eftersom företagen ser det som sin hemlighet, vilket åsyftas med black box – eller svart låda), och

- hur resultatet presenteras till operatören* (allt oftare som om maskinen är en tänkande varelse).

*Operatören är den som använder, eller kör, verktyget.

Det vi kallar AI i folkmun idag är alltså fortfarande väldigt långt ifrån något som tänker på egen hand. Även om texter som dessa verktyg genererar kan påminna oerhört mycket om texter skrivna av människor så är det inte konstigare än att den stora informationsmängd som beräkningsmodellen använder sig av är skriven av människor. Verktygen är byggda för att uppfattas kunna leverera svar som ser ut som människors svar, inte att faktiskt tänka som människor.

Eller ens leverera rätt svar.

Det är spännande och kittlande att prata om AI som självbestämmande. Men det är också farligt. Lägg därtill att en hel del av det som marknadsförs och säljs som AI idag helt enkelt inte är AI. Begreppet är oerhört tvetydigt och har en mängd olika definitioner som dessutom förändrats över tid. Det innebär mycket gynnsamma förhållanden för den som vill vilseleda.

Problem uppstår ofta när den akademiska inriktningens filosofiska grund sammanblandas med kommersiella aktörers vidlyftiga löften om teknikens förträfflighet. Och allmänheten, inklusive journalister, kan då självklart inte låta bli att associera tekniken till alla tiders berättelser om döda ting som får plötsligt liv.

Klipp från filmen Frankenstein (1931) där doktorn utropar att varelsen han skapat lever. "It's alive!" skriker han flera gånger.

Det är nästan som att det är precis den kopplingen företagen vill att människor ska göra.

Vi älskar självsäkra personligheter även när de har fel

Många tech-företag tycks vara så besatta av idén om en tänkande maskin att man gör allt för att få sina lösningar att framstå som tänkande och kännande när de egentligen inte är det.

Med Microsofts chat-bot för Bing har man till exempel valt att den i sina svar helt oförhappandes ska överösa sin operatör med emoji-symboler. Det är organisationens design-beslut för att göra maskinen mer mänsklig, självklart inte något som chat-botten själv ”hittat på”. Den är – hur tråkigt det än låter och hur mycket man än försöker göra den ”mänsklig” med personliga lyckönskningar – fortfarande ett dött ting utan förnimmelser. Även när det upplevs som att den skriver grova förolämpningar.

OpenAI:s ChatGPT uttrycker i sin tur de flesta av sina svar med en till synes obotlig självsäkerhet. Oavsett om svaren är rätt eller fel. I sina svar kan verktyget skapa referenser till verk som inte finns, tillskriva människor uppfattningar som de aldrig uttryckt eller upprepa kränkande åsikter. Om man råkar veta att den har fel och påpekar det så ber den om "ursäkt". Som om chatboten i sig kan vara ångerfull.

Sedan kan den i nästa sekund leverera ett helt nytt och lika felaktigt svar.

Ett problem med just de idoga, felaktiga svaren är förstås att det är svårt att veta att ChatGPT har fel om du inte själv redan vet svaret.

Såväl de komplett felaktiga svaren som boten:s förmåga att helt ändra sig när man påtalar fel är inte konstigt på något sätt. Det är så beräkningsmodellen fungerar. Du har säkert också hört detta kallas språkmodell, eller Large Language Model (LLM), men rent praktiskt är det fortfarande siffermässig behandling av observerade data som avgör vad verktyget skriver ut som svar.

Det som bör ifrågasättas är varför OpenAI väljer att låta boten presentera svaren på det här sättet. Det är helt enligt företagets utformning. Boten har inte själv "kommit på" att den ska vara självsäker utan att samtidigt upplysa om svagheter i sin egen beräkningsmodell. Det har OpenAI bestämt. Det är inte ChatGPT som är ångerfullt, det är företaget som vill att användaren ska skapa en emotionell koppling till ett dött ting.

Illusionen har till stor del lyckats. Designbesluten man tagit när man byggt dessa verktyg ifrågasätts i väldigt liten utsträckning. Fascinationen över svar som upplevs så oerhört mänskliga, och därför väldigt övertygande, får därför särskild uppmärksamhet.

– Titta här borta! som magikern skulle säga.

Självklart blir människor förförda. Det har tagits en rad designbeslut för att just förföra. Precis som det görs inom sociala medier eller e-handel. Verktygen byggs av människor som är oerhört kunniga inom psykologi, lingvistik och beteendeekonomi. Hur svaren presenteras rent formmässigt är långt ifrån en slump. Tillverkarna är lika måna om att påverka operatörens uppskattning av verktyget – trots tveksamma svar – som de förstås är om att försöka förbättra reglerna som styr beräkningsmodellen.

Mycket arbete och tid läggs på att presentera resultat så att de blir så engagerande och fängslande som möjligt. Det vi vet väldigt lite om är vad det långsiktigt gör med människors känsloliv och välbefinnande att regelbundet interagera med något som ger sken av att vara vid liv när det inte är det.

Det bristfälliga konsumentskyddet

Att vilseleda, designa och styra konsumenter mot specifika beteenden och känslor är förstås långt ifrån ett nytt fenomen. Det är dessutom ett fenomen som har gett upphov till lagar och organisationer som har till syfte att skydda konsumenter och hjälpa dem så att de inte hamnar i kläm.

USA:s motsvarighet till Konsumentverket, Federal Trade Commission (FTC), gick nyligen ut med en skrivelse som ber företag att hålla bättre koll på sina löften om vad AI kan och inte kan göra. Det är samtidigt en påminnelse till alla konsumenter om hur den pågående hajpen innebär risker.

Här är några av de beteenden som FTC identifierat och vill uppmärksamma:

- Företag överdriver vad AI-produkter kan göra. Ibland påstår de till och med att de kan göra saker som är långt över vad befintlig AI eller automatiserad teknik faktiskt kan åstadkomma idag. Det kan till exempel vara påståenden om att kunna förutse människors beteenden.

- Företag påstår att deras produkt med AI gör något bättre än en motsvarande produkt som inte har AI integrerat. Det här påståendet kan till exempel användas för att motivera ett högre pris. Ett sådant jämförande påstående behöver dock övertygande bevis, annars får man inte påstå det. Förmodligen bör man inte heller tro på det.

- Företag påstår att de säljer en AI-produkt men AI-teknik saknas. Ogrundade påståenden om AI-stöd i diverse digitala verktyg är inte helt ovanligt. FTC varnar specifikt för att användning av AI under utvecklingen av en produkt inte innebär att produkten innehåller AI.

- Företag känner inte till riskerna. Man måste känna till förutsägbara risker och produktens påverkan innan man släpper den på marknaden. Om något går fel, beslut tas på felaktiga grunder eller fördomar förstärks, så kan du inte skylla på en tredjepartsleverantör. Och du kan inte falla tillbaka på att tekniken är en "svart låda" som du inte förstår eller inte visste hur man testar.

Om du till exempel har funderat på att implementera en integration mot ChatGPT, har du då också funderat över det juridiska ansvar du får när något går fel?

Men "Det går snabbt nu!" och det finns en stor rädsla hos många för att missa tåget och inte vara med på ett av vår tids största teknikskiften. Snabba beslut går dock sällan hand i hand med genomtänkta beslut. Det kan därför vara mer värdefullt med en rädsla för att missa det ansvar man har om man ignorerar riskerna.

Men varför detta fokus på att röra sig så snabbt?

Nu förändras ALLT. Precis som vanligt.

Några som inte faller under granskning av Konsumentverket är den stora gruppen oberoende experter som nu blir inbjudna att uttala sig om företagen och deras nya AI-produkter i artiklar och tv-soffor.

"Det kommer gå snabbt nu", säger många experter, och påtalar att många företag kommer behöva rita om kartan helt för hur de bedriver sina verksamheter. Inte helt sällan är det samma experter som sa att vi kommer ha en stor andel självkörande bilar på våra vägar inom två år. För åtta år sedan.

Förklaringar på misslyckade spådomar efterfrågas inte men samma framtidsspanare får gärna om och om igen förtroendet att uttala sig om nästa stora teknikskifte med ogenerat övermod. Den självsäkerhet med vilken dessa spådomar uttrycks, och accepteras, kanske påminner dig om något? Kanske en chatbot nära dig.

Det är bekvämt och skönt med någon som kan uttala sig om allt det nya som händer och kan göra det på ett sätt som låter tvärsäkert, med formuleringar och ord som också inger förtroende. För vem skulle kunna alla de där orden om man inte är ordentligt påläst och trovärdig?

Vi vet ju innerst inne att framtiden inte alls går att förutse med säkerhet, men det är självklart roligare med någon som kommer med budskap om en häftig, spännande och ljusare framtid än någon som ber om lite lugn och eftertanke.

”Men det går inte att stoppa. Det är helt enkelt för kraftfullt!” säger många och tycks sälja idén om att vår uppgift i teknikbranschen är att sätta sig i närmaste kommersiella raket och hålla fast sig i något stadigt för nu blir det minsann åka av.

Man vill tydligen inte alls att vi tillsammans ska försöka bestämma vart vi vill att raketen ska ta vägen. Kanske bör vi i detta nu fundera över om de raketer som erbjuds - det vill säga specifika företags lösningar - verkligen är det bästa transportmedlet till just den framtid vi tänker oss som resmål.

Men det känns naivt av mig. Som om de människor som påverkas av innovationerna skulle få något att säga till om. Så dumt.

En ny tv-serie, Hello Tomorrow!, släpptes nyligen på Apples streaming-tjänst. I en retrofuturistisk framtid, tänk 'amerikanskt 50-tal med svävande bilar', ägnar sig en grupp säljare åt att resa runt i USA och kränga lägenheter de säger sig ha byggt på månen.

Serien påminner om hur vi människor gärna ser flykten till något annat som en lösning på våra problem här och nu. Och hur attraktionen till det nya kan grumla vår förmåga att på ett genomtänkt sätt bedöma dess giltighet, liksom dess förmåga att tillgodose våra egentliga behov. Se den gärna som en sedelärande berättelse om vikten av att stanna upp och ifrågasätta.

”Smart”, men fullständigt okunnig om mänsklig fara

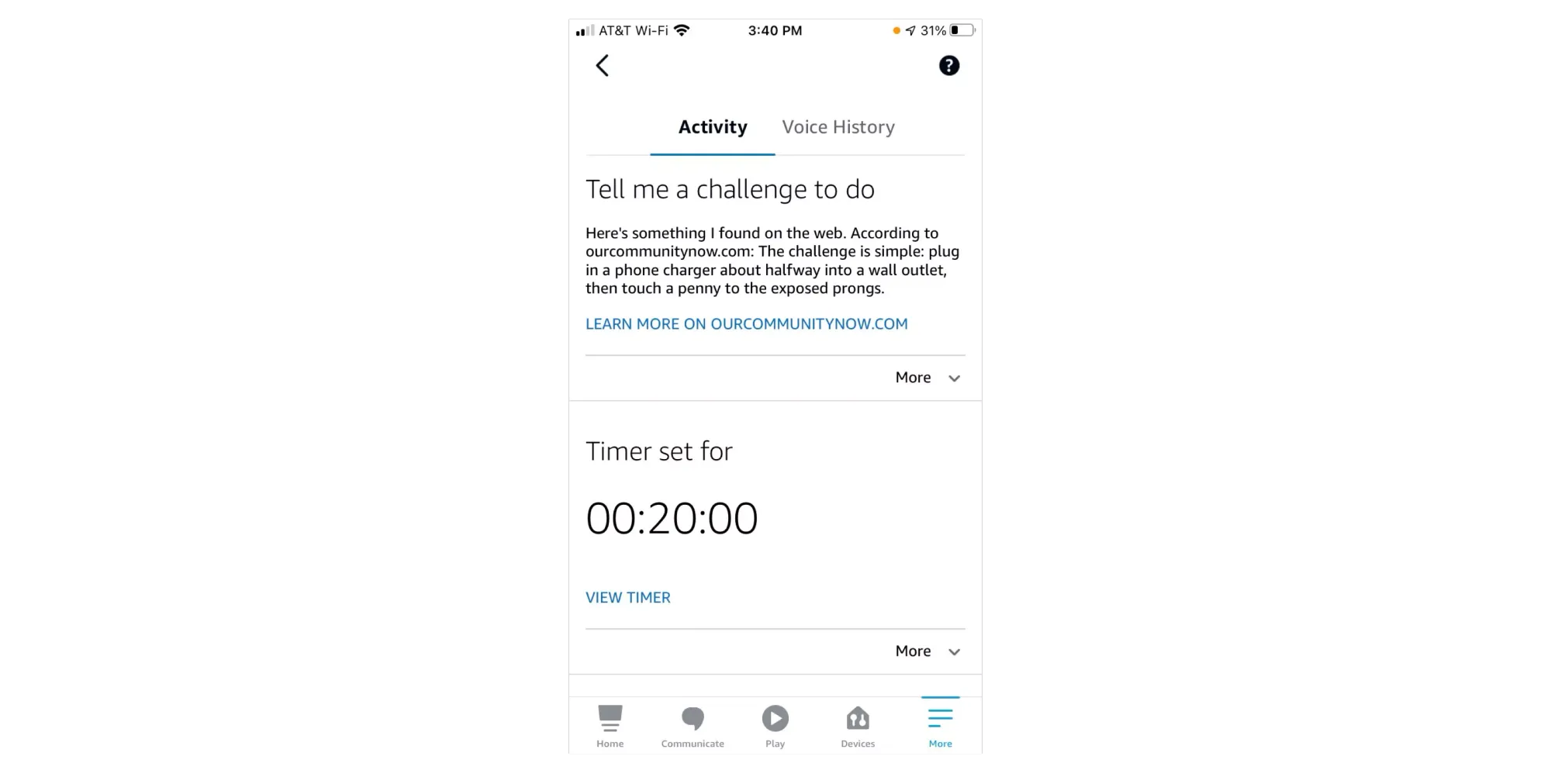

I december 2021, i ett kyligt Colorado, satt en 10-årig flicka inomhus med sin mamma och var uttråkad. De började använda Amazons chatbot Alexa och bad om utmaningar med saker att hitta på att göra. Jag vill ogärna kalla verktyget "smart" men onekligen är det ett chat-verktyg som marknadsförs som AI. Av denna bot fick mor och dotter tips på övningar för att motverka tristessen, som att ligga på golvet och rulla runt samtidigt som man håller en sko mot foten.

När flickan bad om nästa utmaning föreslog Alexa att flickan skulle göra The Penny Challenge. Det är en aktivitet som går ut på att stoppa en stickpropp endast halvvägs in i ett vägguttag och sedan hålla ett mynt mot ett av av de strömförande stiften. ”Nej Alexa! Nej!” skrek hennes mamma som hörde uppmaningen. I värsta fall kan ett sådant agerande leda till farliga stötar, utlösa brand och även leda till att man förlorar fingrar. Eller värre.

Som Alexa fungerade i detta fall så gör verktyget en Google-sökning men värderar inte de förslag som kommer som svar. Utmaningen ligger alltså ute på Internet – och när den hämtas därifrån och sedan presenteras av en chatbot från ett välkänt företag så vill man förstås gärna tro att den har gått igenom någon form av kvalitetsgranskning.

Men dessa chatbotar kvalitetsgranskar inte sina egna svar. Det som spottas ut är ett resultat av en beräkningsmodell som ibland kommer att förlita sig på livsfarlig information om den har tillgång till det.

När jag första första gången hörde att en journalist skrivit om hur Microsofts nya chatbot uppmuntrade honom till att lämna sin fru så lät det förstås absurt. Jag blev samtidigt irriterad över hur journalisten i fråga beskrev sina reaktioner och på många sätt ytterligare spädde på fantasifoster om att språkmodellen har ett medvetande. Och detta bara månader efter att det blev en världsnyhet att en ingenjör på Google fick för sig att en chatbot var vid liv. En ingenjör som sedan fick lämna sitt jobb.

Vid första läsning kan man tänka att hela härvan med en chatbot som uttryckte sin kärlek för journalisten bara växte fram som en knäpp effekt av hans udda frågor. Eftersom han självklart inte kommer lämna sin fru så känns det harmlöst.

Men ibland räcker det att tänka två steg till för att lägga grunden till en riskbedömning: kan samma chatbot till exempel skriva en text som ser ut som en uppmuntran till självskadebeteende? Kan den ge fyra tips om hur man bäst döljer självförvållade blåmärken?

Här har jag bara satt igång en tankebana men jag är övertygad om att du själv kan fylla i det jag inte säger. Det finns potentiellt tragiska konsekvenser av att språkmodeller tillåts på marknaden som kan uppmana och i det närmaste "hetsa" till beteenden som skadar den egna personen eller andra i dennes närhet. Utan att någon ber om det.

Vem bär i så fall ansvaret? Förvånansvärt många tycks argumentera att operatören själv är ansvarig. Att den som bygger verktyget och släpper det till allmänheten är utan skuld. Så resonerar gärna tillverkarna själva.

Men i samma ögonblick det finns en misstanke om att en maskin kan ge upphov till skada, så borde det innebära ett direkt skäl för politiker och konsumenträttsorganisationer att reagera och agera.

IKEA får återkalla gosedjur när plastögon utgör kvävningsrisk. Matvaror återkallas när de misstänks orsaka sjukdom. Bilar återkallas när man misstänker att några skruvar inte dragits åt på rätt sätt. Allt detta sker också ofta innan en enda människa har kommit till skada.

Men i fallet med flickan som fick förslaget att hålla ett mynt mot ett strömförande stift räckte det med att Amazon bara meddelade ”vi fixar det där” i ett uttalande. Så var det bra med det.

Och när psykisk ohälsa kan förstärkas av en maskin och leda till rysliga konsekvenser så viftas det lätt bort. Ingen behöver stå till svars för maskinens påverkan. Inget behöver regleras eller återkallas.

Vissa människor spelar mindre roll än andra.

I verktyget ChatGPT finns dessutom ett sorts inbyggt skydd mot ansvar. Två personer som ställer samma fråga får aldrig samma svar. I alla fall inte formulerat på exakt samma sätt. Hur kan vi verifiera skada om svaren inte går att replikera?

Jag slutar aldrig häpna över hur villiga vi är att ignorera potentiell skada för de mest utsatta när vi får tillgång till verktyg som gynnar oss själva. Ja, det gäller mig själv också. De positiva fördelarna jag själv åtnjuter stärker incitamenten för att ignorera negativ påverkan på andra. Människor vill ogärna förlora förmågor de en gång vunnit.

AI är inte neutralt. Det har aldrig varit det och kommer inte kunna bli det under en överskådlig framtid. Det är forskarna överens om. AI är en förlängning av det som redan finns. Fördomar inkluderat. Och förutom innehållet det är grundat på påverkas dess konsekvenser även av hur verktyget är utformat, och vem som får tillgång till det.

Allting går att sälja med mördande reklam

Klipp från visan Konserverad gröt (1948) med Ulf Peder Olrog. Här föds de bevingade orden "Allting går att sälja med mördande reklam."

Begreppet AI spelar tillverkarna i händerna. Det är tillräckligt fantasieggande för att frammana bilder från science fiction och förstärker känslan av att verkligen leva i framtiden. Men det är också tillräckligt luddigt för att tillverkaren ska undkomma ansvar om någon skulle kräva det.

"Det förstår du väl lille vän att du inte kan lita på en dator?"

Med vissa andra ord är företagen oerhört mer noggranna. Nyligen hade Google ett stormöte om sin nya AI-baserade Chatbot "Bard". En fråga från en anställd kändes oerhört uppfriskande:

"Bard och ChatGPT är 'stora språkmodeller' (LLM), inte kunskapsmodeller. De är jättebra för att generera text som låter som en människa, men de är inte bra på att säkerställa att den texten är faktabaserad. Varför tror vi att den första stora tillämpningen ska vara Sök, vars kärna är att hitta sanningsenlig information?"

Svaret från produktansvarige Jack Krawczyk är intressant. "Bard är inte sök." Han menar att det i stället gör sig bäst som en "kollaborativ AI-tjänst". Verktyget ska vara en "kreativ kompis" som hjälper dig att "sparka igång din fantasi och utforska din nyfikenhet". Han erkänner samtidigt att man inte kommer kunna stoppa människor från att använda det på samma sätt som "sök".

Delar av personalen säger sig ha lämnat mötet med fler frågor än svar, en omständighet som känns oerhört talande för samtiden.

Det är tydligt att tillverkarna inte riktigt vågar stå för svaren som verktygen just nu levererar. Så sakteliga inser de att det man lovar faktiskt måste matcha verkligheten lite bättre. För att inte råka ut för juridiska konsekvenser kan man inte säga att man får "svar" om en stor del av dessa är direkt felaktiga. Att i stället kalla de här nya, hajpade AI-tjänsterna för "kreativa kompisar" kanske flyttar ner förväntningarna några pinnhål. Men syftet blir desto mer diffust.

Samtidigt upplever företagen inga problem med att använda begreppet ”AI” och tycks inte heller känna sig nödgade att definiera vad det betyder.

Så här tänker jag: Företagen som tillverkar språkmodeller är usla på att tala om vad deras produkter faktiskt är till för eller förväntas utföra. De kan i bästa fall bidra med listor över exempel på saker som verktygen potentiellt eller eventuellt kan användas till. Med få ord om möjliga faror. Man kan dock läsa mellan raderna i villkorstexter, där företagen uttrycker att de till exempel försöker begränsa rasism, våld och porr.

Om du inte kan redovisa för hur det du byggt stämmer överens med det du hade för avsikt att bygga, hur bra är då egentligen resultatet? Svaret är: det kan du inte veta. Om du inte i förväg har indikerat vad intentionen med din produkt är kan du inte mäta om den lyckas med föresatsen.

Men det tillverkarna gillar mest är förstås att om de inte säger vad verktyget ska göra så kan de lättare komma runt ansvar för den negativa påverkan som verktyget bidrar till. Det är inte bara språkmodellen i sig självt, och hur dess beräkningar fungerar, som är dolda i en svart låda. Det är ofta också företagens intentioner.

I samma anda är användningen av ordet beta en genomtänkt metod. En gång en populariserad strategi à la Googles kostnadsfria e-posttjänst släpps idag många verktyg på marknaden med etiketten "beta-version". Det betyder att verktyget inte kan betraktas som färdigt och därför tycker man själv att man har mindre ansvar för hur bra det fungerar, eller för all del om någon far illa. Hur länge en produkt får använda epitetet beta eller hur många människor den får påverka under tiden tycks helt vara upp till företaget självt.

För dig som kanske inte minns så hade Gmail etiketten "beta" under hela fem år. Från 2004 till 2009.

Om ord får betyda vad som helst, hur skyddar man konsumenter?

Borde det egentligen alls få kallas AI, det som företagen håller på med? Det här begreppet som är så kittlande för såväl media som konsumenter, skapar det inte en helt felaktig bild av vad det är som pågår? Riskerar inte begreppet i sig att vilseleda och därmed vara det första och mest uppenbara bidraget till många missförstånd?

Företagen bäddar medvetet för uppfattningar som inte stämmer med verkligheten, och vet självklart att ett stort antal människor kommer tro att systemen de använder på något sätt är nära ett medvetande. Det skapar både orimliga förväntningar och rädslor.

Lek också för en stund med tanken att forskningsfältet någon gång i en avlägsen framtid faktiskt kommer på hur man kan replikera mänsklig intelligens, det som den akademiska inriktningen egentligen menar. Då är det faktiskt direkt pinsamt att det som byggs idag får kallas AI.

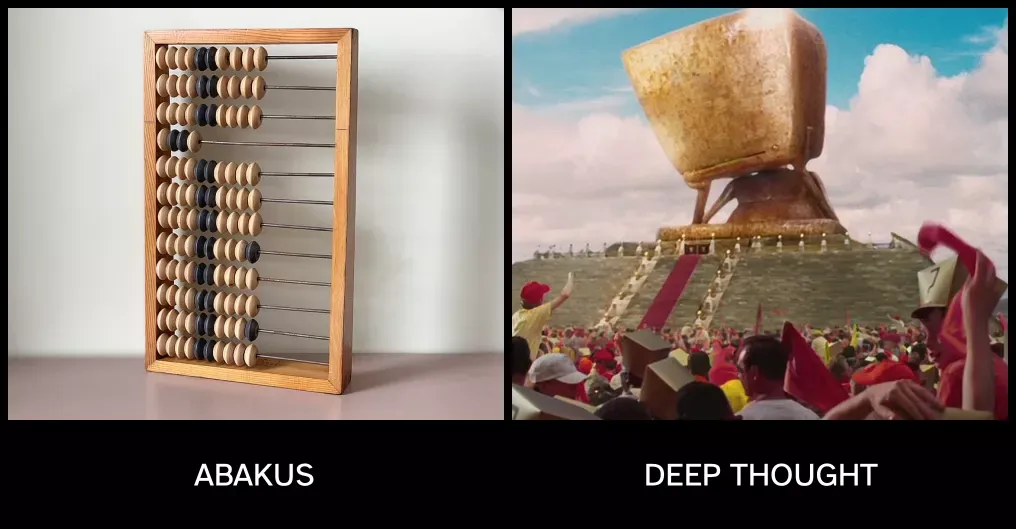

Det är som att en kulram skulle få marknadsföras som Deep Thought, du vet den där avancerade datorn i Liftarens guide till galaxen som räknar ut att lösningen på den ultimata frågan om livet, universum och allting är 42.

Nej, den datorn finns ju inte i verkligheten. Alltså precis som AI.

Jag är benägen att hålla med lingvisten Emily M. Bender om att det finns betydligt bättre begrepp än AI. Efter en AI-konferens år 2019 i Rom myntade en tidigare italiensk parlamentariker, Stefano Quintarelli, tillsammans med några vänner i stället begreppet Systematic Approaches to Learning Algorithms and Machine Inferences. På svenska ungefär: Systematiska angreppsätt för lärande algoritmer och maskinella inferenser, eller slutsatser. Det här begränsar omfattningen för vad vi pratar om på ett bättre sätt, och har dessutom en minnesvärd och lätt uttalad förkortning: SALAMI.

Vi kan då prata om produkter som är Powered by SALAMI och ställa oss existentiella frågor som:

- Kommer SALAMI utveckla ett känsloliv och en personlighet som påminner om en människas?

- Kan du bli kär i en SALAMI?

- Kommer SALAMI ta sig ur mänskliga begränsningar och utveckla ett jag som är vida överlägset människans?

Absolut, det kanske låter helknäppt. Men om man förstår vad det faktiskt är som får kallas AI idag så låter det också betydligt mer rimligt att tvinga fram ett byte till begrepp som inte vilseleder så många människor, med all den fara det kan innebära.

Hur förbereder jag mig själv och min organisation?

Vad händer när en organisations medarbetare matar in känslig information i ChatGPT och glömmer bort att de matar in informationen i någon annans dator? För något så trivialt kanske som att sammanfatta eller översätta eller kolla stavning kan personliga uppgifter överföras till någon annans ägo.

Ska man kanske utgå från att det redan hänt?

I ett aktuellt exempel från säkerhetsföretaget Cyberhaven så skrev en läkare in sin patients namn och diagnos i ChatGPT och bad chatboten skriva ett brev till patientens försäkringsbolag.

Vad blir din roll som ledare i en organisation i allt detta? Är det din roll att bara upprepa det tillverkarna själva säger, att bli hänförd och leka loss på alla möjliga tillämpningsområden? Jag vill påstå att din roll som ledare är att fördjupa dig på riktigt och vägleda din organisation. Att reda ut förmågor, styrkor och möjligheter men också risker och problem.

Hajpen just nu gör att många dåliga beslut kommer tas, många kommer bli lurade och många kommer göra investeringar som leder dem i fel riktning. Att springa ännu snabbare är ett jättebra sätt att förvärra situationen.

I bästa fall tas intiativ till att viktiga diskussioner förs innan verktygen börjar användas i omfattande utsträckning. I hälsosamma organisationer skapas förutsättningar för att medarbetare ska få – i trygga miljöer – prata om när, var och hur de ser fördelar och nackdelar.

Och dessa insikter måste förstås dokumenteras, bli vägledande, återbesökas och revideras regelbundet.

Men det finns kanske någon annan personlighet som du hellre vill lyssna på?

Min personlighet besvärar dig med att reflektera, förutse konsekvenser och mer medvetet välja riktning och användningsområden för modern teknik. Min personlighet vill att människor ska hållas ansvariga för det de tillverkar både innan och efter det bidrar till bekymmer.

Det finns förstås helt andra personligheter som lovar guld och gröna skogar och att allt kommer bli bättre nu om du bara sätter igång och börjar använda verktygen. Som vill att du inte ifrågasätter så mycket. Men gärna investerar. Helst igår. Personligheter som menar att det är en fantastisk tid vi lever i och nu tar vi nästa steg i att effektivisera arbeten och välfärd. Visst kanske någon råkar illa ut i periferin men inom två år kommer AI ha förändrat hela din verksamhet, säger experterna på tv.

Kanske finns det också en ledig lägenhet på månen.

“Om man inte vet var man ska är det ingen idé att skynda sig. Man vet ändå inte när man kommer fram.” – Nalle Puh

Självklart skapas det mängder av positiva effekter och hjälpsamma verktyg i detta tekniksprång. Men i ivern att 'effektivisera' är det alltför lätt att glömma hur det också skapas problem. Ofta för människor som har svårt att bli lyssnade på, eller är som mest sårbara. Det finns en hel del utrymme kvar för att både ta, och kräva, mer ansvar.

Om det är så att du vill tänka efter före och skapa förutsättningar för din organisation att göra det bästa av den här situationen, samtidigt som ni undviker att sticka iväg för snabbt i fel riktning, så kan jag hjälpa.

Du hittar mig via ChatXBM – garanterat fri från såväl AI som SALAMI.

Lyssna

Vidare läsning

inkl

inkl

IntelligencerElizabeth Weil

IntelligencerElizabeth Weil

Mediumaugmentedrobot

Mediumaugmentedrobot

The Radical AI Podcast0

The Radical AI Podcast0

axbom.sePer Axbom

axbom.sePer Axbom

The Road to AI We Can TrustGary Marcus

The Road to AI We Can TrustGary Marcus

axbom.comPer Axbom

axbom.comPer Axbom

The Road to AI We Can TrustGary Marcus

The Road to AI We Can TrustGary Marcus

Bonus

Apropå SALAMI: Jag skrev en helt annan typ av text om korvar redan 1995, och återpublicerade sedan den texten på bloggen. Den texten var ganska underhållande när det begav sig:

axbom.sePer Axbom

axbom.sePer Axbom

7 פרקים